Newsletter du CeSIA #3

Mobilisation des talents français, loi européenne sur l’IA, sommet sur l’IA en Corée du Sud et polémiques autour d’OpenAI

Bienvenue sur la newsletter du Centre pour la Sécurité de l'IA ! Le CeSIA est une nouvelle organisation qui vise à promouvoir un développement sûr et bénéfique de l’intelligence artificielle pour tous. Retrouvez ici les dernières actualités et ressources sur l'intelligence artificielle, sa sécurité et sa gouvernance.

Certains des liens fournis renvoient vers des textes en anglais, pour lesquels nous avons inclus un lien vers une traduction française “(fr)” générée par Google, quand c’était possible.

Actualités françaises et européennes

La position de la France sur l’IA révèle une prise de conscience progressive de l’importance de cette technologie, mais aussi une méconnaissance des risques.

L'IA est réaffirmée comme priorité stratégique pour la France, et le président Macron a annoncé une nouvelle série de mesures, dont un nouveau fonds d'investissement dans l'IA de 400 millions d’euros pour former 100 000 experts par an sur ces technologies au sein de différents pôles d’excellences “IA Cluster”, pour rendre la France de l’IA plus attractive et plus indépendante.

Après le sommet de Bletchley Park qui s’est tenu en novembre 2023, puis celui de Séoul qui s’est déroulé le mois dernier, durant lequel la France a plaidé pour une gouvernance internationale de l’IA, la troisième édition du Sommet sur la sécurité de l’IA, renommé Sommet pour l’action sur l’IA, se tiendra en France les 10 et 11 février 2025, tel qu’annoncé par le président lors d’un rassemblement des plus grands talents français de l'IA. Comparé aux deux sommets précédents, le Sommet pour l’action sur l’IA aborde des sujets plus diversifiés (fr) et notablement moins focalisés sur la sécurité de l’IA.

Alors que l’Europe continue à mettre en place les différents dispositifs européens autour de l’AI Act, la CNIL poursuit ses travaux pour une IA innovante et respectueuse de la vie privée en proposant des fiches pratiques, afin d’aider les acteurs économiques et territoriaux à adopter les nouveaux outils numériques dans les différents cadres légaux. Autre acteur majeur français, l’Inria travaille également pour construire une IA digne de confiance en Europe, et a, durant Vivatech, signé avec le Laboratoire National de Métrologie et d'Essai (LNE, qui propose déjà des services d’évaluations) un partenariat pour la constitution d’un programme « Evaluation de l’IA » à travers un centre d’évaluation en IA, possiblement dans le cadre de la déclaration de Séoul pour la constitution d’un réseau international d’instituts sur la sécurité de l’IA.

Après son adoption le 13 mars, le règlement européen “AI Act” pour réguler l’intelligence artificielle a été définitivement adopté par l’Union européenne. Afin de le rendre opérationnel et de contrôler son application, l'Union européenne a créé un bureau de l'IA chargé de réguler les technologies de l’IA. 140 personnes (spécialistes en technologie, juristes et économistes) seront chargées d'ici à 2026 de cette nouvelle législation de l'UE, avec pour objectifs de favoriser l'innovation et limiter les risques de dérives. Il a tenu son premier webinaire sur la logique de gestion des risques de la législation sur l’IA et des normes connexes.

Dans un même temps, la Cour des comptes européenne fustige le manque d'investissement de l'UE pour développer l’écosystème de l’IA en Europe, dévoilant un rapport dans lequel les investissements de l’UE sont jugés insuffisants au regard de ses ambitions mondiales affichées. Sont notamment dénoncés des problèmes de coordination. Et si les risques ont été particulièrement étudiés, cela ne semble pas avoir été le cas des cibles d’investissement.

Actualités mondiales

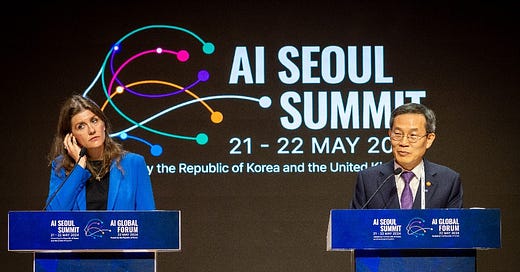

La seconde édition (fr) du Sommet pour la sécurité de l’IA s’est tenue en Corée du Sud les 21 et 22 mai dernier.

Rappelons que, lors de la première édition, des groupes de la société civile avaient exprimé leurs préoccupations dans une lettre ouverte (fr), concernant la mise à l’écart de certains sujets (sur les impacts négatifs déjà ressentis de l’IA) au profit d’autres (risques à long termes), et de l’absence de représentants de pays du Sud ou de certaines communautés. De plus, quelques acteurs présents ne se sont décidés à participer à cette seconde édition qu’après l’action de groupes défendant les idées (fr) de la sécurité de l’IA.

Avec les constats d’évolutions majeures du paysage de l’IA en juste six mois après la première édition du sommet, de lacunes dans la forme de la gouvernance globale de l’IA, mais également avec le souhait de rebondir sur les premiers bénéfices de l’IA et d’adopter une démarche favorisant son développement pour le bien de tous (notamment afin de relever des défis globaux comme la pauvreté ou la crise climatique), les initiateurs (fr) de cette seconde édition voulaient se pencher sur les nouveaux risques apportés par l’IA, et demander aux entreprises comment celles-ci les évaluent et y répondent au sein de leur organisation.

Parmi les engagements pris :

Le “Seoul AI Business Pledge” (fr) : seize entreprises majeures dans le domaine de l’IA se sont engagées à adopter des mesures de sécurité, en signant le “Frontier AI Safety Commitments” (fr), à appliquer aux modèles et services qu’elles publieront, en respectant les différentes initiatives découlant des questionnements et préoccupations sur les impacts des IA sur la société. Elles se déclarent notamment favorables à des audits externes menés par des instituts en sécurité de l’IA. Elles s’engagent ainsi à « ne pas développer ou déployer un modèle ou un système » dont les mesures de sécurité ne permettraient pas de « maintenir les risques en dessous de seuils fixés ». Mais ces seuils ne seront pas définis avant le prochain Sommet sur l’IA, en 2025 en France.

La France, l’Allemagne, l’Italie, le Royaume-Uni, les États-Unis, Singapour, le Japon, la Corée du Sud, l’Australie et le Canada se sont engagés à la création d’un réseau d’instituts (fr) similaire au “AI Safety Institute” (fr) anglais, en travaillant ensemble pour lancer un réseau international afin d’accélérer les progrès de la science de la sécurité de l’IA.

La déclaration de Séoul (fr) : les représentants de 28 pays et des responsables d’organisations internationales ont adopté la déclaration de Séoul (fr) visant à promouvoir la sécurité, l’innovation et l’inclusion de l’IA.

OpenAI : doutes et scandales

En tant que pionnier de l'intelligence artificielle, tant sur le plan technologique que dans l'opinion publique, OpenAI a une responsabilité toute particulière en ce qui concerne les questions de sécurité de l'IA.

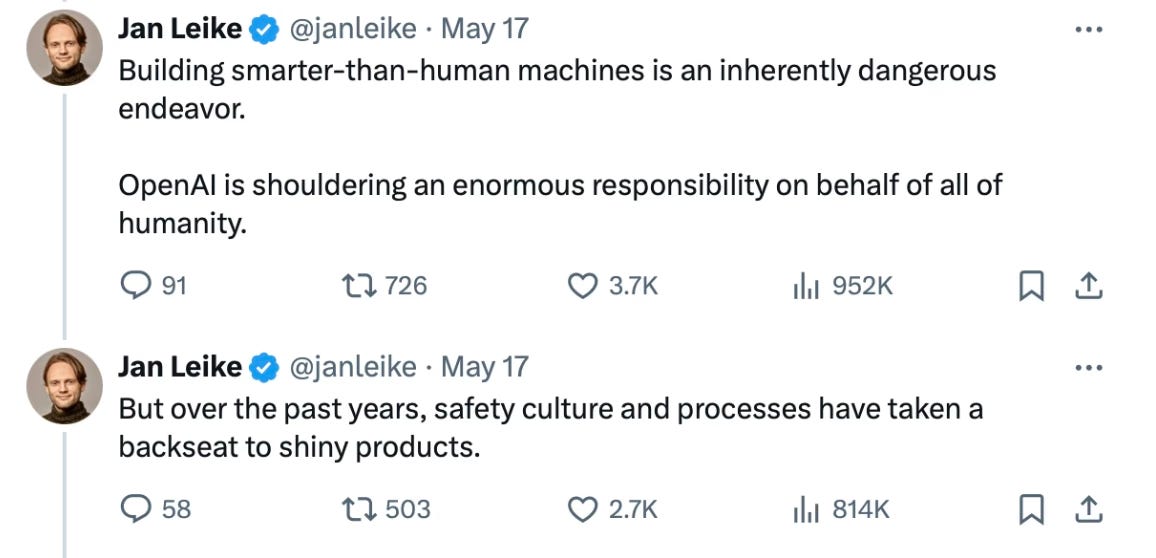

En juillet 2023, l’entreprise constituait son équipe Superalignment, dirigée par Jan Leike et Ilya Sutskever, avec pour mission de résoudre les problèmes scientifiques et techniques pour diriger et contrôler les systèmes d’IA d’ici 2027, à l’aide de 20% des capacités de calculs d’OpenAI, une promesse qui n’a pas été tenue (fr).

Cependant, Jan Leike et Ilya Sutskever ont quitté OpenAI, marquant la dissolution de Superalignment. Ils citent comme raison une perte de confiance (fr) dans l’administration et la mission d’OpenAI : Leike a déclaré que l’entreprise a perdu sa culture de la sécurité au profit de produits tapageurs, et a été réembauché par Anthropic, concurrent d’OpenAI connu pour son approche plus respectueuse des risques. Sutskever a préféré fonder sa propre entreprise avec pour objectif de construire une superintelligence sans risques.

Le sentiment qu’OpenAI a abandonné sa mission première de créer une technologie révolutionnaire pour le bien de l’humanité est partagé par de nombreux (ex-)employés de l’entreprise. Certains, comme Daniel Kokotajlo, ont dû abandonner une grande partie de leur compensation financière pour leur travail à OpenAI (sous forme d’actions) afin de se libérer d’un accord de confidentialité, qui pose la question de combien d’autres membres d’OpenAI sont tenus au silence. C’est pourquoi des lanceurs d’alerte réclament un “droit à avertir sur l’IA avancée” (fr) afin de lutter contre les dynamiques vicieuses qui poussent les entreprises d’IA à négliger les aspects de sécurité dans leur course à l’IA.

Les préoccupations de ces ex-employés dans leur lettre (fr) portent sur des problèmes bien connus de la sécurité de l’IA, pour lesquels nous n’avons à ce jour toujours pas de réponse satisfaisante, de la désinformation à la perte de contrôle des systèmes autonomes qui pourraient mener à l’extinction de l’humanité.

Un autre membre de Superalignment qui a été renvoyé, Leopold Aschenbrenner a publié un essai alarmant (fr) sur la nécessité de faire de l’IA une priorité nationale : selon Aschenbrenner, il faut s’attendre à des progrès extrêmement rapide en IA dans la décennie à venir, et se préparer autant en matière de sécurité (résoudre les problèmes techniques d’alignement irrésolus) que de sûreté (s’assurer que les technologies d’IA ne soient pas obtenues par la Chine). Cet essai a été critiqué notamment pour sa perspective agressive du “monde libre” contre la Chine, mais jugé intéressant pour sa tentative de prédiction des avancées futures de l’IA par extrapolation des tendances actuelles.

Si ces sentiments négatifs sont avérés, quelle en est la source ? Il est probable que les tensions actuelles soient liées à la tentative en novembre 2023 de renvoyer l’actuel PDG d’OpenAI, Sam Altman. Ses mouvements décrits comme manipulateurs ont directement ou indirectement conduit au départ des employés les plus soucieux de la sécurité de l’IA et les plus opposés à Sam Altman ; on peut donc s’attendre à ce que l’entreprise prenne une approche moins mesurée dans sa recherche, son développement et son déploiement de modèles.

Suite à la dissolution de Superalignment, OpenAI a annoncé un nouveau comité chargé de sécurité et de sûreté pour conseiller son conseil d’administration, mais étant dirigé par Sam Altman et d’autres membres du conseil d’administration, on est en droit de douter de l’utilité pratique de ce comité, au delà du safety-washing.

En perdant la confiance de ses employés les plus soucieux (puis les renvoyant ou les faisant démissionner), OpenAI apparaît d’autant moins capable de gérer les risques liés à l’IA. Étant donné son expertise et sa position à la pointe de la technologie, une lettre ouverte (fr) a été publiée, affirmant qu’il est nécessaire de demander des comptes et des mesures de contrôle à l’entreprise afin de s’assurer qu’elle ne foncera pas tête baissée

Actions du CeSIA

Le CeSIA co-organise avec Entrepreneur First un AI Safety meetup à station F le 24 juin.

Dialogues de Turing

Nous organisons le prochain cycle des “Dialogues de Turing”, des tables rondes ouvertes à toutes et à tous sur les enjeux de l'IA. Voici les prochaines :

Mardi 25 juin : L'intelligence artificielle, alliée ou menace pour la cybersécurité ? (détail et inscription)

Mardi 9 juillet : Comment concilier sécurité, éthique et compétitivité dans le développement de l'IA ? (détail et inscription)

Les dialogues de Turing sont enregistrés sur notre chaîne YouTube.

Introduction à la Sécurité de l’IA

Conférence introductive au sujet ouverte à toutes et à tous, ne nécessite aucune expertise en IA.

Le 28 juin à l’école 42.

Nos publications

Nous commentons sur LinkedIn :

Au sujet de l’article “A Benchmark for Learning to Translate a New Language from One Grammar Book”

Au sujet de la dissolution de l’équipe Superalignment d’OpenAI

Notre chaîne YouTube présente certains enregistrements des dialogues de Turing.

Nous sommes intervenus récemment sur les podcasts du Futurologue et de Thibault Neveu.

Nous avons publié le benchmark BELLS afin d’évaluer la fiabilité des systèmes d’évaluation des LLM. BELLS analyse des traces d’exécution de LLM pouvant contenir des anomalies, afin de vérifier si un système de monitoring est capable de repérer ces anomalies, permettant ainsi d’évaluer ces systèmes, de les comparer, et de stimuler leur développement afin de les rendre plus efficaces et plus généraux.

Liens / en bref

Robert Miles, chercheur en IA résume ses impressions sur l’IA en 2023 : L’IA a ruiné mon année.

L’annotation de données requiert du travail humain dans des conditions inacceptables aux Philippines et au Kénya : Les forçats de l’IA - OpenAI accusé de pratiquer de « l’esclavage moderne » pour entrainer ChatGPT.

Nouveau succès d’Anthropic en interprétabilité : l’article en ligne d’Anthropic “Cartographier l’esprit d’un LLM ” (fr) et une synthèse journalistique (fr).

Roman Yampolskiy, chercheur en IA, est très pessimiste quant aux risques encourus par l’humanité : Les dangers d’une superintelligence artificielle. Un résumé est disponible : Il y a 99,9 % de risques que l'intelligence artificielle entraîne la fin du monde, selon un chercheur en IA

Exposé compréhensif des capacités, risques et solutions pour l’IA : Rapport scientifique international sur la sécurité de l’IA avancée (fr), supervisé par Yoshua Bengio.

Microsoft permet à l’assistant intelligent de Windows d’accéder à un nouvel historique, appelé Recall, qui enregistre tout ce qui apparaît à l’écran. Cette fonctionnalité ne fait pas l’unanimité.

Parmi les impacts sociaux de l’IA, les doubleurs des voix françaises de cinéma et de télévision se mobilisent à travers une pétition.

OpenAI est accusée d’avoir imité la voix de l’actrice Scarlett Johansson dans son dernier modèle capable de produire des voix humaines.

Le baromètre 2024 IFOP pour TALAN présente une tendance et une évolution de l’adoption des IA génératives en France : les Français en seraient de plus en plus accros.

AI Overviews : la dernière fonctionnalité ajoutée par Google à son moteur de recherche présente encore des bugs, même si certains sont corrigés, illustrant la fragilité de la robustesse des IA génératives.

Common corpus : un jeu de données pour une IA générative qui respecte le droit d'auteur, disponible sur Hugging Face (fr) depuis mars dernier.

Vous pouvez retrouver tous les évènements du CeSIA sur Luma et nous suivre sur LinkedIn pour ne rien manquer !

Une question ? Une opinion à partager ? Une info à ajouter ? Contactez-nous sur notre site ou venez discuter avec nous sur Discord !

Pour vous renseigner sur les risques, vous pouvez aussi étudier notre manuel de sécurité de l’IA (en cours d’écriture).